Un grupo de científicos ha desarrollado una tecnología experimental llamada ‘mind captioning’ (descripción o subtitulado mental) que intenta convertir en texto sencillo lo que una persona ve y recuerda, según se explica en el estudio publicado el viernes en la revista científica Science Advances.

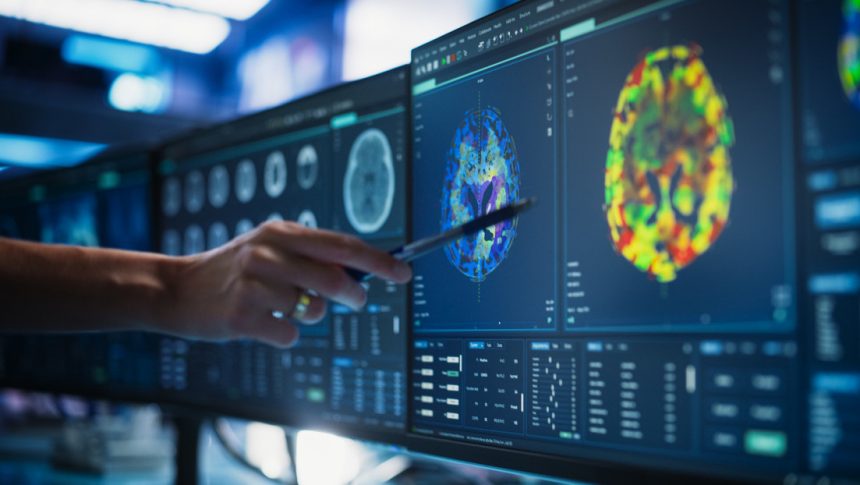

En el artículo se detalla el diseño del experimento en el que seis voluntarios se acostaron en un escáner de resonancia magnética mientras veían videoclips rápidos y un sistema informático trataba de escribir oraciones que describieran lo que ocurría en su mente.

Tomoyasu Horikawa, científico del Instituto de Estudios Avanzados de la Universidad de Tokio que dirigió el estudio, explicó que el objetivo no era adivinar palabras aisladas como “perro” o “coche”, sino generar frases completas que indicaran quién actúa, qué hace y dónde sucede la escena, lo que es más difícil.

Así funciona el ‘mind captioning’

Horikawa definió su enfoque como “mind captioning” porque el sistema toma patrones específicos de actividad cerebral y los transforma en breves subtítulos. Los investigadores utilizaron los modelos de lenguaje de OpenAI, ChatGPT 4o mini y 3.5 como decodificadores.

Inicialmente, observadores humanos fijaron descripciones para cada uno de los clips que se iban a mostrar —con ejemplos como, “un niño acaricia un perro en el jardín”—. Esas oraciones se introdujeron en un modelo de lenguaje que convierte el texto en una representación numérica (vector de significado).

Para cada voluntario del experimento se estableció un decodificador individual que enlazó el patrón de actividad cerebral resultante por cada clip con la representación numérica correspondiente a esas imágenes, de esta forma se vinculan las respuestas cerebrales con los significados de las oraciones.

A continuación, un segundo modelo lingüístico se encarga de construir la frase legible.

Este modelo parte de muy poco texto, a veces de un simple marcador vacío, y sugiere una oración inicial. A continuación, el sistema compara el significado de esta frase con la representación calculada a partir de la actividad cerebral.

Si hay diferencias, el modelo de IA oculta algunas palabras y las reescribe, manteniendo solo las versiones que mejor encajan con el significado decodificado. Al repetir este proceso varias veces, la frase se va ajustando y se vuelve más coherente con lo que la persona está viendo en el video.

Resultados y límites del sistema

Los investigadores señalaron que, si bien las oraciones generadas están lejos de ser perfectas, a menudo se acercan bastante a los subtítulos originales de los clips. En algunos casos, el sistema comete errores concretos, como llamar “lobo” a un perro, aunque conserva la estructura básica de la escena, por ejemplo, un animal persiguiendo algo o una persona sosteniendo un objeto.

Para evaluar la precisión, el equipo utilizó únicamente el texto generado por el modelo para intentar identificar el video que estaba viendo el voluntario. El clip correcto se seleccionó muchas más veces de las que se esperaría por azar y superó a métodos anteriores basados en representaciones más simples.

Describir escenas recordadas y no solo lo que se ve

Tras la fase de entrenamiento, los participantes permanecieron en el escáner y se les pidió que recordaran en silencio escenas específicas de los videos, esta vez sin imágenes en la pantalla. La misma IA realizó la ‘lectura’ de ese periodo de recuerdo y produjo descripciones. Los resultados encajaban mejor con los clips recordados que con otros no relacionados.

La precisión resultante fue menor que cuando los voluntarios estaban viendo directamente los videos. Este resultado se presentó como una muestra de que el método puede reflejar no solo la información sensorial inmediata, sino también los contenidos mentales internos basados en la memoria.

¿Qué zonas del cerebro codifican el significado?

Horikawa analizó también qué partes del cerebro contenían patrones que el modelo podía decodificar. El sistema continuó funcionando incluso cuando se excluyeron de los análisis las áreas clásicas del lenguaje. Este descubrimiento indicó que las regiones visuales de alto nivel y las zonas parietales (responsables de integrar la información sensorial) eran portadoras de información rica sobre el significado de las escenas.

Los modelos centrados en el reconocimiento de detalles visuales, como formas y texturas, se ajustaron mejor a las áreas sensoriales tempranas. Por el contrario, los modelos que usaban rasgos semánticos basados en el lenguaje coincidieron más con la actividad de las regiones superiores. Los datos sugieren que estas zonas se centran más en los conceptos y las relaciones que en la apariencia en sí.

Posibles aplicaciones de la nueva técnica

En el ámbito de la neurociencia básica, los investigadores señalaron que el ‘mind captioning’ abre una vía para estudiar cómo el cerebro representa eventos complejos y pensamientos con un nivel de detalle similar al de las oraciones. El portal de divulgación científica Earth señaló que esto podría ayudar a trazar con mayor precisión la relación entre la actividad neuronal y el significado.

En el ámbito médico y tecnológico, se plantea la posibilidad de combinar decodificadores personalizados con sensores cerebrales para ayudar a personas que no pueden hablar o moverse. En ese escenario, parte de su experiencia interna podría salir al exterior en forma de texto, lo que ofrecería una nueva forma de comunicación asistida.

Los autores subrayaron que este decodificador no ‘lee la mente’ en el sentido de revelar secretos ocultos ni de entender a una persona como lo haría un amigo cercano. No obstante, señalaron que ya es capaz de traducir patrones complejos de actividad neural en lenguaje estructurado, algo que solo se ha vuelto posible recientemente gracias a la combinación de imágenes cerebrales y modelos lingüísticos modernos.

DERECHOS DE AUTOR

Esta información pertenece a su autor original y se encuentra en el sitio https://actualidad.rt.com/actualidad/576311-nueva-tecnologia-experimental-traducir-pensamientos?utm_source=rss&utm_medium=rss&utm_campaign=all